Lohnt sich ChatGPT im Unternehmen?

Viele Unternehmen fragen sich: Ist das mehr Spielerei oder auch strategisch sinnvoll? Die ehrliche Antwort lautet: Es kommt darauf an. Und zwar auf drei Dinge: den konkreten Anwendungsfall, die vorhandene Datenlage – und die Bereitschaft zur organisatorischen Veränderung.

- Use Case: Gibt es Prozesse mit hohem Textaufkommen, vielen Wiederholungen oder manuellem Rechercheaufwand?

- Datenzugang: Stehen strukturierte oder zumindest gut auffindbare Inhalte (z. B. FAQs, Richtlinien, CRM-Notizen) zur Verfügung?

- Reifegrad: Ist die Organisation bereit, Prozesse anzupassen – nicht nur Tools einzuführen?

Zahlen, die den Rahmen setzen:

- Laut einer MIT x BCG Studie (2023) berichten Consultants von bis zu 40–50 % Zeitersparnis bei textbasierten Aufgaben durch den Einsatz von GPT-4.

- In Leafworks-Projekten mit Zendesk-Automatisierung konnten bis zu 25 % schnellere Reaktionszeiten im First-Level-Support erzielt werden.

- Die Einstiegskosten sind niedrig: Einzelnutzer zahlen ab 20 €/Monat, kleine Integrationsprojekte starten bei rund 5.000 €.

Fazit: ChatGPT lohnt sich, wenn der Einsatz mit klarer Zielsetzung erfolgt. Ohne Kontext, Daten und Prozessanpassung bleibt der Effekt oft aus.

Mehr zu unseren Erfahrungen im Kundenservice mit KI →

Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo.

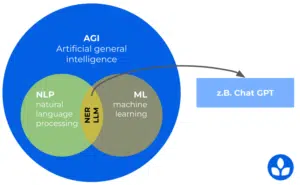

Was ChatGPT ist – und warum das für Unternehmen relevant ist

ChatGPT basiert auf einem sogenannten Large Language Model (LLM), das durch maschinelles Lernen aus Milliarden Textbeispielen Sprachmuster erkennt und reproduziert. Dadurch kann ChatGPT in Sekundenschnelle sprachbasierte Aufgaben übernehmen. Im Unternehmenskontext ist das relevant, um:

- Inhalte schneller und konsistenter zu erstellen – ob im Kundenservice, Marketing oder HR

- Wissen standortübergreifend nutzbar zu machen – z. B. bei Einarbeitung, Support oder interner Kommunikation

- wiederkehrende Aufgaben zu automatisieren, ohne neue Systeme einzuführen

Was Unternehmen sich von ChatGPT erhoffen – und wie sich das erreichen lässt

Viele Unternehmen starten mit ChatGPT, doch die größten Effekte entstehen meist dort, wo generative KI in bestehende Systeme und Workflows integriert wird – zum Beispiel in CRM-, Service- oder Wissensprozesse. Hier kommen Lösungen wie etwa die vielfältigen Zendesk AI-Features ins Spiel, die generative Funktionen in klar definierten Kontexten nutzbar machen.

| Erwartung an ChatGPT | Was Unternehmen sich darunter vorstellen | Wie KI in echten Unternehmenssystemen umgesetzt wird (Beispiele) |

|---|---|---|

| schnellere Ergebnisse | Automatische Antworten, Textvarianten, Zusammenfassungen | Generative KI in Tools wie Zendesk AI Copilot, Office-Suite, Wissensmanagement-Systemen |

| Wissen besser nutzbar machen | GPT „weiß alles“, findet alles | Systeme mit strukturierter Wissensbasis: Help Center, interne Handbücher, Confluence, CRM-Daten |

| Routine reduzieren | GPT übernimmt Standardtexte und wiederkehrende Aufgaben | KI-gestützte Workflows: Ticketklassifikation, Dokumenten-Summary, HR/IT-Self-Service, CRM-Automationen |

| Qualität steigern | GPT prüft Tonalität & Inhalt | KI-basierte QA-Funktionen in Tools wie Zendesk QA, Grammarly Business, Content-Guidelines |

| Skalieren ohne mehr Personal | GPT arbeitet parallel mit | Produktive KI-Agents in Systemen wie Zendesk AI Agents, Workflow-Automatisierung, Chatbots |

| Onboarding erleichtern | GPT erklärt Prozesse | KI-gestützte Assistenzsysteme, Schritt-für-Schritt-Anleitungen, automatisierte Ticket- oder Dokumentensummaries |

| mehrsprachig arbeiten | GPT übersetzt alles automatisch | integrierte Sprach- & Intent-Erkennung: Language Detection, Multilingual Bots, Translation Add-ons |

| Analyse verbessern | GPT erkennt Trends in Texten | KI-Analytics: Stimmungsanalyse, Mustererkennung, Volumenprognosen, Workforce-Forecasting |

Einstiegsszenarien und Kosten

Der Weg zu einem produktiven KI-Einsatz ist individuell. Manche Teams starten mit einfachen Textautomationen, andere integrieren Large Language Models direkt in bestehende Systeme. Drei Einstiegsmodelle haben sich in der Praxis bewährt:

1. Direktnutzung (Einzelpersonen + kleine Teams)

Tools wie chat.openai.com, ChatGPT, Microsoft Copilot oder Notion AI ermöglichen schnelle Experimente – ideal, um erste Effekte zu testen oder interne Aufgaben zu beschleunigen.

Typische Einsatzfelder:

- Textvarianten, Zusammenfassungen

- Rechercheunterstützung

- Ideation für Marketing und HR

Kosten: 20–50 €/Monat pro Nutzer*in

Limitierung: Kein Unternehmenskontext, keine Kontrolle über Datenflüsse, keine Prozessintegration.

2. Integration in bestehende Systeme

Hier werden KI-Funktionen direkt in Tools eingebettet, die Teams ohnehin täglich nutzen. Das ist meist der Punkt, an dem aus Experimenten echte Produktivität entsteht.

Beispiele:

- generative Funktionen in CRM- und Supportsysteme

- KI-basierte Klassifikation und Zusammenfassung

- automatisierte Workflows (z. B. HR-, IT- oder Service-Prozesse)

Konkreter Praxisfall: Wenn Unternehmen Zendesk nutzen, greifen viele auf Zendesk AI-Funktionen oder AI-Apps wie die von Knots zurück – Copilot, AI Agents oder KI-Analysen sind dann bereits im System verankert, DSGVO-konform und rollenbasiert steuerbar.

Kostenrahmen für Integrationsprojekte:ca. 5.000–15.000 €, je nach Systemlandschaft, Schnittstellen, Rollen Use Cases

3. Eigene KI-Lösungen / Custom GPTs

Unternehmen, die sehr spezifische Anforderungen haben oder volle Datenhoheit benötigen, entwickeln eigene GPT-Anwendungen oder LLM-basierte Services.

Typische Motive:

- interne Wissensmodelle

- domänenspezifische Assistenten

- komplexe Automationslogiken

Achtung: hohe Integrations- oder Sicherheitsanforderungen

Kosten: ab ca. 20.000 €(inkl. API-Einbindung, Datenaufbereitung, Prompt Engineering, Monitoring)

Voraussetzungen für den erfolgreichen KI-Einsatz

KI bringt nur dann echten Nutzen, wenn die Rahmenbedingungen stimmen. Viele Unternehmen scheitern nicht an der Technologie, sondern an fehlenden Grundlagen: Daten, Strukturen, Zuständigkeiten oder klaren Prozessen. Vier Voraussetzungen haben sich als entscheidend erwiesen:

1. Verlässliche Wissensquellen

LLMs sind nur so gut wie der Kontext, den sie erhalten. Unternehmen benötigen gut strukturierte oder zumindest auffindbare Inhalte – z. B.:

- FAQs, interne Richtlinien, Produkt- und Prozessbeschreibungen

- CRM-Notizen oder Kundenhistorien

- Wissensdatenbanken, Confluence-Spaces, Help Center

Fehlt diese Basis, muss zuerst an der inhaltlichen Struktur gearbeitet werden – sonst bleiben die Ergebnisse unzuverlässig.

2. Klarheit über Datenflüsse & Datenschutz

Bevor KI im Unternehmen eingesetzt wird, müssen grundlegende Fragen beantwortet werden:

- Welche Daten dürfen verarbeitet werden – und welche nicht?

- Wer hat Zugriff?

- Wie werden Inhalte geprüft, freigegeben und dokumentiert?

- Welche Rollen dürfen KI-Funktionen nutzen?

Ohne Governance entsteht Schatten-KI. Tools wie Zendesk, Microsoft, Atlassian oder Dedicated-LLM-Umgebungen (z. B. Azure OpenAI) bieten hier kontrollierbare Rahmenbedingungen.

3. Kontextkompetenz statt nur Prompting

Prompting ist wichtig, aber im Unternehmenskontext längst nicht die wichtigste Fähigkeit. Relevant ist, wie gut Teams:

- Probleme klar formulieren

- den nötigen Kontext bereitstellen

- Ergebnisse prüfen und weiterverarbeiten

- KI als Baustein in bestehenden Workflows nutzen

Prompting ist daher nicht „Trickwissen“, sondern Teil eines produktiven Dialogs zwischen Mensch, System und Modell.

4. Prozess- und Organisationsreife

KI kann nur verbessern, was bereits funktioniert. Ohne definierte Prozesse, Rollen und Verantwortlichkeiten verstärkt KI chaotische Strukturen eher, als sie zu lösen.

Reife Organisationen zeichnen sich aus durch:

- konsistente Prozesse (Support, HR, IT, Sales, Marketing)

- klare Eskalationswege

- verlässliche Datenqualität

- dokumentierte Abläufe

- technische Integrationsfähigkeit

Gerade in Systemen wie Zendesk, Microsoft oder ERP-Umgebungen zeigt sich: KI wirkt am stärksten dort, wo der Prozess klar ist – nicht dort, wo das Modell „magisch“ arbeiten soll.

Kurz gesagt:

Der Einsatz von ChatGPT & Co. ist nicht primär eine technische Frage, sondern eine Frage von Daten, Strukturen, Prozessen und Organisation. Wer die Grundlagen schafft, holt schnell spürbare Vorteile. Wer sie ignoriert, kommt kaum über Experimente hinaus.

Exkurs: Was gute Prompts wirklich ausmacht

Prompting ist ein Dialog, kein Einwegbefehl. Gute Prompts basieren auf:

- Rollenbewusstsein: Wer spricht – ein Produktmanager, eine Agentin, ein Bot?

- Zielorientierung: Was soll entstehen – Information, Handlung, Vorschlag?

- Kontexttiefe: Für wen, auf welchem Kanal, mit welchem Wissensstand?

- Feedbackfähigkeit: Gute Ergebnisse brauchen Iteration – und Nachfragen.

- Erprobten Mustern: Kürzel wie „TL;DR“, „ELI5“ oder „Humanize“ beschleunigen den Workflow.

Prompting lässt sich standardisieren, dokumentieren und teamübergreifend nutzbar machen – z. B. über Templates oder eine interne Prompt-Bibliothek.

Risiken & Grenzen

Generative KI eröffnet enorme Potenziale – bringt aber Risiken mit, die Unternehmen bewusst steuern müssen. Vier Punkte sind in der Praxis besonders relevant:

1. Halluzinationen & mangelnde Verlässlichkeit

LLMs erzeugen Inhalte, auch wenn Fakten fehlen oder falsch sind. Selbst gute Prompts verhindern nicht, dass Modelle plausible, aber fehlerhafte Antworten liefern. Deshalb braucht jedes Ergebnis Prüfung, Kontext und Regeln für den Einsatz.

2. Intransparenz („Blackbox“)

Warum ein Modell zu einer bestimmten Antwort kommt, ist in vielen Fällen nicht nachvollziehbar. Das ist kein technischer Fehler, sondern ein Architekturprinzip von LLMs. Unternehmen brauchen Leitlinien, wann KI als Vorschlag dient – und wann Entscheidungen bei Menschen bleiben.

3. Datenschutz & Schatten-KI

Ohne klare Vorgaben entstehen schnell unsichere Praktiken: private Accounts, Copy-Paste sensibler Inhalte oder unkontrollierte Freigaben. Sichere Rahmenbedingungen (z. B. Azure OpenAI, kontrollierte Integrationen, Rollenmodelle) sind Voraussetzung, bevor KI breit genutzt wird.

4. Überschätzte Wirkung

Viele starten mit KI, ohne Ziel, Daten oder Prozessklarheit. Die Folge: keine spürbare Verbesserung – manchmal sogar mehr Aufwand. Der größte ROI entsteht dort, wo KI in bestehende Systeme und Prozesse eingebettet wird, nicht in isolierten Experimenten.

Fazit: Was ChatGPT leisten kann – und wann Beratung sinnvoll ist

ChatGPT ist kein Hype-Thema mehr, sondern ein Werkzeug, das Unternehmen echte Vorteile bringen kann – vorausgesetzt, die Grundlagen stimmen.

Teams, die strukturiert vorgehen und KI sinnvoll in ihre Arbeitsabläufe integrieren, erzielen messbare Effekte: schnellere Ergebnisse, konsistentere Inhalte, weniger Routinearbeit und bessere Wissensnutzung.

Der Schlüssel liegt dabei nicht im Modell, sondern in:

- klaren Use Cases

- sauberen Daten

- passenden Systemen

- guten Prozessen

- und einem realistischen Erwartungsrahmen

Genau hier setzen wir an. Leafworks unterstützt euch dabei:

- den passenden Einstieg zu finden – ob klein, integriert oder strategisch

- KI in bestehende Systeme einzubinden (z. B. Zendesk, interne Tools, CRM)

- kompetente Nutzung im Team aufzubauen – inkl. Prompting & Kontextarbeit

- Daten und Arbeitsabläufe datenschutzkonform nutzbar zu machen

Kurz: Wir bieten Sparring, Struktur und Erfahrung – damit KI nicht beim Experiment bleibt, sondern Wirkung entfaltet.

KI verändert CX. Nur wie genau, wissen die wenigsten.

Drei wissenschaftliche Deep Dives in Webinar-Form: Wie ändert KI

- das Verhalten von Kund:innen,

- die Arbeit im Service und

- strategische Entscheidungen im Unternehmen?

Künstliche Intelligenz rollt die Frage nach Customer Experience neu auf – begleitet Dr. Florian Bühler auf der fundierten Suche nach belastbaren Antworten.